Нейт Ланксон, Bloomberg.com

Світ переповнений дипфейками — відео, аудіо чи зображеннями, які змушують людей робити або говорити те, чого вони не робили, або бути десь там, де вони не були.

Багато з них створені для того, щоб надати довіри брехні та завдати шкоди репутації політиків та інших людей в очах громадськості. Але більшість дипфейків — це відверті відео та зображення, створені шляхом відображення обличчя знаменитості на тілі іншої особи. Саме це сталося наприкінці січня, коли фальшиві відверті зображення поп-зірки Тейлор Свіфт поширилися в соціальних мережах. Тепер, коли штучний інтелект дозволяє майже будь-кому створити реалістичні зображення та звук кількома натисканнями на клавіатурі, стає все важче визначити, чи те, що ви бачите та чуєте в Інтернеті, є реальним.

Що сталося з Тейлор Свіфт?

Фальшиві зображення Свіфт широко поширювалися в соціальних мережах, викликаючи гнів легіонів її шанувальників. Одне зображення, опубліковане на X, сайті, раніше відомому як Twitter, переглянули 47 мільйонів разів, перш ніж обліковий запис було призупинено, повідомляє New York Times. X заявив, що працює над видаленням «усіх ідентифікованих зображень» і вживе «відповідних заходів» проти тих, хто їх опублікував. Свіфт також була серед знаменитостей, голосами та зображеннями яких маніпулювали, щоб вони рекламували комерційні продукти — у випадку Свіфт — популярну марку посуду.

Де ще в новинах були дипфейки?

Раніше в січні Кочіта Гомез, 17-річна актриса серіалу Marvel, розповіла про те, що знайшла відверто сексуальні дипфейки з її обличчям у соціальних мережах і не змогла добитися видалення матеріалу, повідомляє NBC News. Діпфейки також з’являються під час президентських виборів у США 2024 року. Жителі Нью-Гемпшира отримали автоматичний дзвінок перед президентськими виборами штату, який звучав так, ніби президент Джо Байден закликав їх залишатися вдома та «зберегти свій голос на виборах у листопаді». Голос навіть вимовив одну з фірмових фраз Байдена: «Яка купа негідників».

Як створюються дипфейкові відео?

Вони часто створюються за допомогою алгоритму штучного інтелекту, який навчено розпізнавати шаблони в реальних відеозаписах конкретної людини, процес, відомий як глибоке навчання. Тоді можна замінити елемент одного відео, наприклад обличчя людини, на інший фрагмент вмісту, щоб це не виглядало як грубий монтаж. Ці маніпуляції вводять в оману найбільше, коли використовуються з технологією клонування голосу, яка розбиває аудіозапис, де хтось говорить, на півскладові фрагменти, які можна знову зібрати в нові слова, які, здається, вимовляє особа в оригінальному записі.

Як технологія deepfake злетіла?

Спочатку технологія була сферою вчених і дослідників. Однак Motherboard, видання Vice, повідомило в 2017 році, що користувач Reddit під назвою «deepfakes» розробив алгоритм для створення фейкових відео з використанням відкритого коду. Reddit забанив користувача, але практика поширилася. Спочатку deepfakes вимагали відео, яке вже існувало, і реального вокалу, а також кмітливих навичок редагування. Сучасні генеративні системи ШІ дозволяють користувачам створювати переконливі зображення та відео на основі простих письмових підказок. Попросіть комп’ютер створити відео, яке вкладає слова в чиїсь уста, і воно з’явиться. Цифрові підробки стало важче помітити, оскільки компанії зі штучним інтелектом застосовують нові інструменти до величезної кількості матеріалів, доступних в Інтернеті, від YouTube до бібліотек зображень і відео.

Які ще приклади дипфейків?

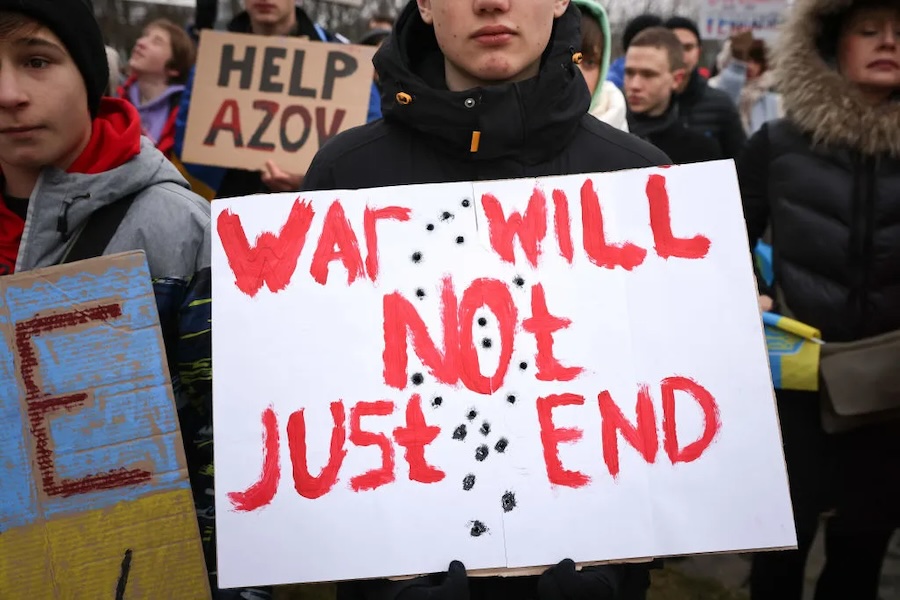

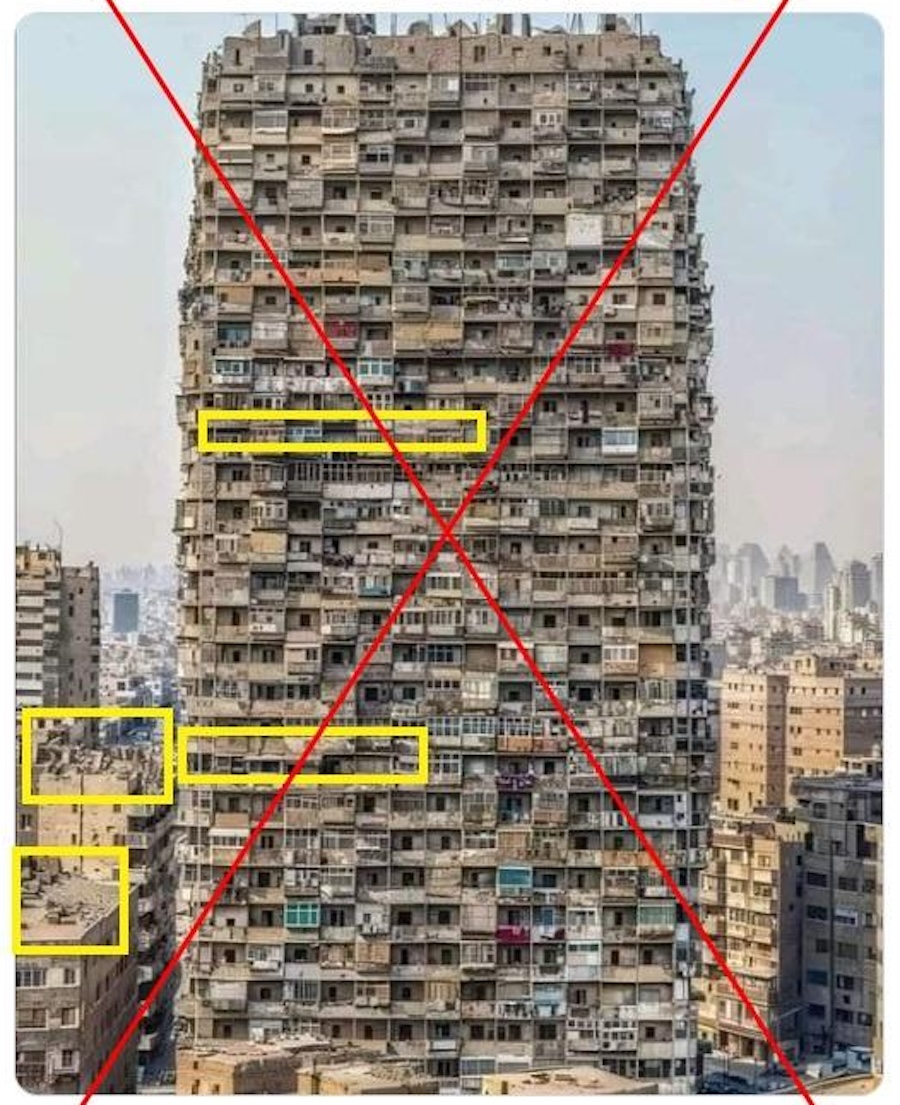

Китайські тролі розповсюдили підроблені зображення лісових пожеж у серпні на гавайському острові Мауї, щоб підтвердити твердження, що вони були спричинені секретною «погодною зброєю», яку випробовують США. У травні 2023 року американські акції ненадовго впали після того, як в Інтернеті поширилося зображення, на якому зображено Пентагон у вогні. Експерти кажуть, що підроблене зображення мало ознаки створення ШІ. Того лютого з’явився сфабрикований аудіозапис із тим, що нібито кандидат у президенти Нігерії Атіку Абубакар планує сфальсифікувати голосування того місяця. У 2021 році в соцмережах з’явилося хвилинне відео, на якому президент України Володимир Зеленський каже своїм солдатам скласти зброю та здатися Росії.

У чому тут небезпека?

Побоювання полягає в тому, що дипфейки з часом стануть настільки переконливими, що неможливо буде відрізнити реальне від вигаданого. Уявіть собі, як шахраї маніпулюють цінами на акціях, створюючи підроблені відеоролики про те, як керівники публікують корпоративні оновлення, або фальсифіковані відео солдатів, які скоюють військові злочини. Політики, бізнес-лідери та знаменитості особливо ризикують, враховуючи, скільки доступних записів із ними. Ця технологія робить можливим так зване порно помсту, навіть якщо воно насправді не оголене – зазвичай спрямоване на жінок. Коли відео стає вірусним в Інтернеті, його практично неможливо стримати. Додаткове занепокоєння полягає в тому, що поширення обізнаності про дипфейки полегшить людям, яких дійсно зафіксовано на записі, коли вони роблять або говорять неприйнятні чи незаконні речі, стверджувати, що докази проти них є фальшивими. Деякі люди вже використовують глибокий фейковий захист у суді.

Чи з цим щось робиться?

Тип машинного навчання, який створює глибокі фейки, не може бути легко скасований, щоб виявити їх. Але кілька стартапів, таких як нідерландська Sensity AI і естонська Sentinel, розробляють технологію виявлення, як і багато великих технологічних компаній США. Корпорація Intel запустила продукт FakeCatcher у листопаді 2022 року, який, за її словами, може виявляти підроблене відео з точністю 96%, спостерігаючи за тонкими змінами кольору на шкірі об’єкта, викликаними кровотоком. Компанії, включно з Microsoft Corp., пообіцяли вставляти цифрові водяні знаки в зображення, створені за допомогою своїх інструментів ШІ, щоб відрізнити їх як підроблені.

Законодавчі збори штатів США рухалися швидше, ніж Конгрес, щоб вирішити безпосередню шкоду ШІ. Кілька штатів прийняли закони, які регулюють дипфейки, переважно в контексті порнографії та виборів. Запропонований Закон Європейського Союзу про штучний інтелект вимагатиме від платформ позначати дипфейки як такі.